Introduction

Une enquête récente menée par Cybernews a révélé la plus grande fuite de mots de passe jamais enregistrée. Il a été confirmé que 16 milliards d’identifiants de connexion, incluant des mots de passe, ont été exposés. Ces données concernent des utilisateurs de services en ligne majeurs tels qu’Apple, Facebook, Google, ainsi que d’autres plateformes, notamment les réseaux sociaux, les services VPN, les portails développeurs et divers services gouvernementaux.

And more:https://t.co/HPwV0ytWxn

— Kol Tregaskes (@koltregaskes) June 19, 2025

Ce qu’il s’est passé

Les chercheurs ont conclu que cette fuite massive est le résultat de multiples infostealers (malwares spécialisés dans le vol d’informations). Ces malwares ont collecté les identifiants directement depuis des appareils infectés, et non suite à une compromission directe des plateformes concernées.

Les données volées ont été compilées en 30 ensembles distincts de données exposés. Chacun de ces ensembles est massif, contenant entre plusieurs dizaines de millions et plus de 3,5 milliards d’enregistrements. Ces enregistrements sont constitués d’identifiants de connexion (noms d’utilisateur et mots de passe), généralement structurés sous forme d’URL suivie des identifiants correspondants.

Cette structuration permet un accès immédiat à tous types de services en ligne, y compris des plateformes telles qu’Apple, Facebook, Google, GitHub, Telegram, ainsi que divers portails gouvernementaux.

Ce qui est particulièrement préoccupant, selon les chercheurs, c’est que la majorité de ces jeux de données n’avaient jamais été signalés comme compromis auparavant, ce qui les rend nouveaux, organisés et immédiatement exploitables par des acteurs malveillants.

🚨 16 BILLION CREDENTIALS LEAKED — LARGEST DATA BREACH IN HISTORY!

— Numbers.lk (@numberslka) June 19, 2025

⭕ Cybernews researchers located 30 unsecured datasets holding ~16 billion login credentials from infostealer malware, each with tens of millions to 3.5 billion entries.

⭕ Affected services include Apple,… pic.twitter.com/7ARNdPa330

Nos Recommandations:

Les violations de mots de passe représentent un problème grave et récurrent pouvant entraîner la prise de contrôle frauduleuse de comptes et une grande exposition de votre identité numérique. Compte tenu de la gravité de cet incident, nous vous recommandons vivement d’agir sans attendre :

- Modifiez immédiatement vos mots de passe sur tous les services critiques.

- Activez l’authentification multifacteur (MFA/2FA) partout où cela est possible : cela ajoute une couche de sécurité supplémentaire.

- Utilisez un gestionnaire de mots de passe pour générer et stocker des identifiants robustes et uniques pour chaque service, améliorant ainsi l’hygiène de vos mots de passe.

- Adoptez les passkeys dès que disponibles : le passage des mots de passe aux passkeys est fortement conseillé. Google recommande à des milliards d’utilisateurs d’adopter cette technologie plus sécurisée, déjà intégrée par des entreprises comme Apple et Facebook.

Cadre de réponse en cybersécurité:

- VMRay souligne que les malwares voleurs d’informations tels que RedLine, Raccoon et Vidar constituent l’un des principaux vecteurs de vol d’identifiants. Ces programmes malveillants collectent des données sensibles à partir des navigateurs, VPN, applications de messagerie et portefeuilles cryptographiques afin de contourner les mécanismes de sécurité et permettre des attaques ultérieures telles que l’élévation de privilèges ou les rançongiciels. La solution DeepResponse de VMRay permet une analyse dans un bac à sable (sandbox) des fichiers ou liens suspects, tandis que TotalInsight contribue à la validation des menaces via l’IA et la corrélation. Link

- CrowdStrike rapporte que les attaquants utilisent souvent des identifiants valides pour se faire passer pour des utilisateurs légitimes et éviter d’être détectés. Les méthodes les plus fréquentes incluent le phishing, les attaques par force brute, l’extraction de la mémoire LSASS et le Kerberoasting. Falcon OverWatch recommande de mettre en place une authentification multifacteur robuste (MFA), de maintenir une bonne hygiène informatique grâce à Falcon Discover, et de mener une chasse aux menaces continue pour atténuer ces risques.

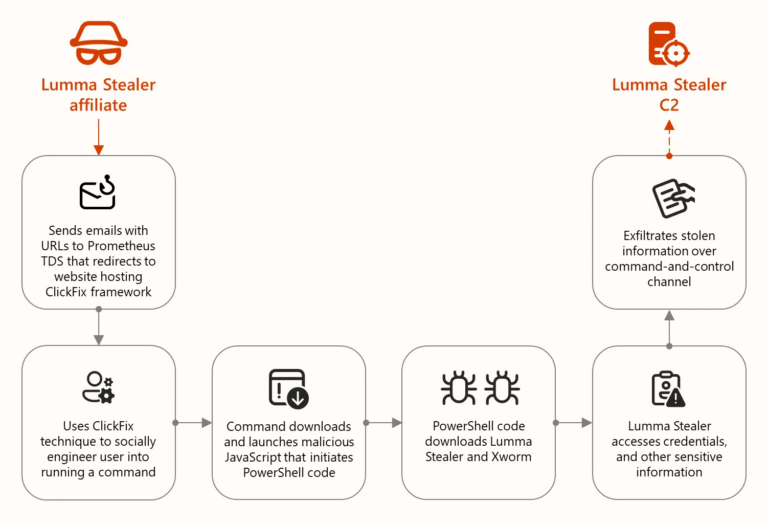

- Selon Microsoft, Lumma Stealer (Storm-2477) est un malware proposé en tant que service (Malware-as-a-Service) qui subtilise des données provenant des navigateurs, portefeuilles cryptographiques et diverses applications. Il se propage via des campagnes de phishing, de publicités malveillantes (malvertising) ou d’applications compromises, et évite la détection à l’aide de techniques comme le process hollowing et une infrastructure C2 protégée. Microsoft recommande de renforcer Defender for Endpoint et les capacités XDR, d’activer une MFA résistante au phishing, et d’utiliser Microsoft Edge avec Defender SmartScreen. Link

Notre Centre des opérations de sécurité (SOC) renforce sa vigilance et assure une surveillance continue afin de détecter tout signe d’attaque ou d’activité suspecte :

- Notre équipe de Cyber Threat Intelligence (CTI) mène activement des investigations pour identifier tout client potentiellement affecté.

- Le SOC reste en alerte maximale, assurant une veille permanente des menaces et comportements anormaux.